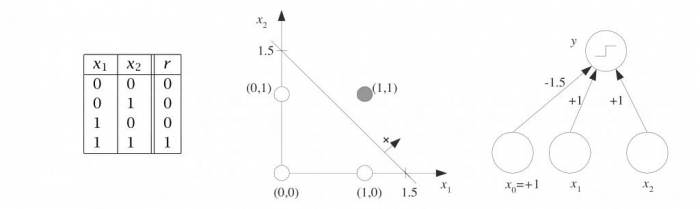

У машинному навчанні персептрон – це алгоритм контрольованого навчання двійкових класифікаторів. Також він часто називається перцептроном. Бінарний класифікатор – це функція, яка може вирішити, чи належить вхід, представлений вектором чисел, якогось певного класу. Це тип лінійного класифікатора, тобто алгоритм класифікації, який робить свої прогнози на основі функції лінійного предиктора, що об’єднує набір ваг з вектором ознак.

В останні роки штучні нейронні мережі привернули увагу завдяки досягненням в області глибокого навчання. Але що таке штучна нейронна мережа і з чого вона складається?

Познайомтеся з персептроном

У цій статті ми коротко розглянемо штучні нейронні мережі в цілому, потім розглянемо один нейрон і, нарешті (це частина кодування), ми візьмемо саму базову версію штучного нейрона, персептрон, і класифікуємо її точки на площині.

Ви коли-небудь замислювалися, чому існують завдання, які настільки прості для будь-якої людини, але неймовірно важкі для комп’ютерів? Штучні нейронні мережі (скорочено ANN) були натхненні центральною нервовою системою людини. Як і їх біологічний аналог, ANN побудовані на простих елементах обробки сигналів, які об’єднані у велику сітку.