Для чого потрібен robots.txt?

Як ви вже здогадалися, цей файл є провідником роботів в корінь сайту. Зараз його використовують для того, щоб частково обмежити доступ до небажаного контенту:

- сторінки з особистою інформацією користувачів;

- сайти-дзеркала;

- видача пошукових результатів;

- форми відправки даних та ін.

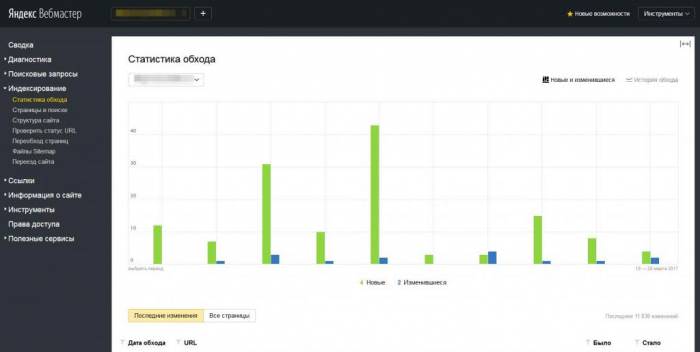

Якщо в корені сайту немає файлу robots.txt, то робот просканує абсолютно весь контент. Відповідно, у видачі можу з’явитися небажані дані, а значить, постраждаєте і ви, і сайт. Якщо ж в документі robots.txt є особливі вказівки, значить, «павук» буде слідувати їм і видасть інформацію, бажану власнику ресурсу.

Робота з файлом

Щоб з допомогою robots.txt закрити сайт від індексації, необхідно розібратися з тим, як створити цей файл. Для цього необхідно слідувати інструкції:

Як бачите, на одному з етапів необхідно встановити команди для роботів. Вони бувають двох типів: дозволяють (Allow) і заборонні (Disallow). Також деякі оптимізатори можуть вказати швидкість обходу, хост і посилання на карту сторінок ресурсу.

Для того щоб почати роботу з robots.txt і повністю закрити сайт від індексації, необхідно також розібратися у використовуваних символах. Наприклад, в документі можна використовувати «/», який вказує на те, що сайт обраний цілком. Якщо ж використовується «*», значить, потрібна послідовність символів. Таким чином можна буде вказати конкретну папку, яку можна сканувати, або не можна.